لماذا تستمر شركات التكنولوجيا في ارتكاب أخطاء عنصرية باستخدام الذكاء الاصطناعي

في عام 1998 ، قمت عن غير قصد بإنشاء خوارزمية ذكاء اصطناعي متحيزة عنصريًا. هناك دروس في تلك القصة يتردد صداها بقوة أكبر اليوم.

مخاطر التحيز والأخطاء في خوارزميات الذكاء الاصطناعي معروفة الآن. لماذا ، إذن ، كانت هناك موجة من الأخطاء الفادحة من قبل شركات التكنولوجيا في الأشهر الأخيرة ، لا سيما في عالم روبوتات الدردشة AI ومولدات الصور؟ تم إنتاج الإصدارات الأولية من ChatGPT إخراج عنصري. أظهر كل من مولدات الصور DALL-E 2 و Stable Diffusion التحيز العنصري في الصور التي قاموا بإنشائها.

عيد الغطاس الخاص بي كرجل أبيض عالم الحاسوب أثناء تدريس فصل في علوم الكمبيوتر وقع في عام 2021. كان الفصل قد شاهد للتو قصيدة فيديو بقلم Joy Buolamwini ، باحث وفنان في مجال الذكاء الاصطناعي ووصفوا أنفسهم شاعر الكود. قصيدتها الفيديو 2019منظمة العفو الدولية ، ألست امرأة؟هو عرض مدمر لمدة ثلاث دقائق للتحيز العنصري والجنساني في أنظمة التعرف التلقائي على الوجوه – الأنظمة التي طورتها شركات التكنولوجيا مثل Google و Microsoft.

غالبًا ما تفشل الأنظمة في النساء ذوات البشرة الملونة ، وتصنفهن بشكل غير صحيح على أنهن ذكور. بعض الإخفاقات فظيعة بشكل خاص: شعر زعيمة الحقوق المدنية السود إيدا ب. تم تصنيف امرأة سوداء أخرى على أنها تمتلك “شارب الفظ”.

يتردد عبر السنين

لقد مررت بلحظة ديجا فو رهيبة في فصل علوم الكمبيوتر: تذكرت فجأة أنني أيضًا قد صنعت ذات مرة خوارزمية متحيزة عنصريًا. في عام 1998 ، كنت طالبة دكتوراه. تضمن مشروعي تتبع حركات رأس الشخص بناءً على مدخلات من كاميرا فيديو. لقد قام مستشار الدكتوراه الخاص بي بتطويره بالفعل التقنيات الرياضية لمتابعة الرأس بدقة في مواقف معينة ، ولكن يجب أن يكون النظام أسرع وأكثر قوة. في وقت سابق من التسعينيات ، باحثين في مختبرات أخرى أظهر أنه يمكن استخراج المناطق ذات لون الجلد من الصورة في الوقت الفعلي. لذلك قررنا التركيز على لون البشرة كإشارة إضافية للمتعقب.

لقد استخدمت كاميرا رقمية – لا تزال نادرة في ذلك الوقت – لالتقاط بضع لقطات من يدي ووجهي ، كما أنني التقطت يدي ووجوه شخصين أو ثلاثة أشخاص آخرين كانوا في المبنى. كان من السهل استخراج بعض البكسلات الملونة بالجلد يدويًا من هذه الصور وإنشاء نموذج إحصائي لألوان البشرة. بعد بعض التعديلات والتبديل ، كان لدينا وقت حقيقي قوي بشكل مدهش نظام تتبع الرأس.

بعد فترة وجيزة ، طلب مني مستشاري عرض النظام لبعض المسؤولين التنفيذيين الزائرين في الشركة. عندما دخلوا الغرفة ، غمرني القلق على الفور: المديرين التنفيذيين كانوا يابانيين. في تجربتي غير الرسمية لمعرفة ما إذا كان نموذج إحصائي بسيط سيعمل مع نموذجنا الأولي ، قمت بجمع البيانات من نفسي وحفنة من الآخرين الذين تصادف وجودهم في المبنى. لكن 100٪ من هؤلاء كانت بشرتهم “بيضاء”. التنفيذيون اليابانيون لم يفعلوا ذلك.

بأعجوبة ، عمل النظام بشكل جيد على المديرين التنفيذيين على أي حال. لكنني شعرت بالصدمة من إدراك أنني قد خلقت نظامًا متحيزًا عنصريًا كان من الممكن أن يفشل بسهولة بالنسبة للأشخاص الآخرين من غير البيض.

الامتياز والأولويات

كيف ولماذا ينتج العلماء ذوو التعليم الجيد وذو النوايا الحسنة أنظمة ذكاء اصطناعي متحيزة؟ توفر النظريات الاجتماعية للامتياز عدسة مفيدة واحدة.

قبل عشر سنوات من إنشائي لنظام تتبع الرؤوس ، اقترحت الباحثة بيجي ماكنتوش فكرة “حقيبة غير مرئيةيحملها البيض. يوجد داخل الحقيبة كنز دفين من الامتيازات مثل “يمكنني القيام بعمل جيد في موقف مليء بالتحديات دون أن يُنسب الفضل إلى عرقي” ، و “يمكنني انتقاد حكومتنا والتحدث عن مدى خوفي من سياساتها وسلوكها دون أن أكون يُنظر إليه على أنه دخيل ثقافي “.

في عصر الذكاء الاصطناعي ، تحتاج هذه الحقيبة إلى بعض العناصر الجديدة ، مثل “أنظمة الذكاء الاصطناعي لن تعطي نتائج سيئة بسبب عرقي”. ستحتاج أيضًا الحقيبة غير المرئية للعالم الأبيض إلى: “يمكنني تطوير نظام ذكاء اصطناعي بناءً على مظهري الخاص ، وأعلم أنه سيعمل بشكل جيد لمعظم المستخدمين.”

https://www.youtube.com/watch؟v=QxuyfWoVV98

الباحثة في مجال الذكاء الاصطناعي والفنانة جوي بولامويني قصيدة الفيديو “AI ، ألست أنا امرأة؟”

أحد العلاجات المقترحة لامتياز البيض هو أن تكون نشطًا مناهضة العنصرية. بالنسبة لنظام تتبع الرأس لعام 1998 ، قد يبدو واضحًا أن العلاج المضاد للعنصرية هو التعامل مع جميع ألوان البشرة على قدم المساواة. بالتأكيد ، يمكننا ويجب علينا التأكد من أن بيانات تدريب النظام تمثل نطاق جميع ألوان البشرة على قدم المساواة قدر الإمكان.

لسوء الحظ ، هذا لا يضمن أن جميع ألوان البشرة التي يلاحظها النظام سيتم التعامل معها على قدم المساواة. يجب أن يصنف النظام كل لون ممكن على أنه جلد أو غير جلد. لذلك ، توجد ألوان مباشرة على الحدود بين الجلد وغير الجلد – يطلق علماء الكمبيوتر في المنطقة على حدود القرار. سيتم تصنيف الشخص الذي يتجاوز لون بشرته حدود هذا القرار بشكل غير صحيح.

تواجه أيضًا معضلة غير واعية سيئة عند دمج التنوع في نماذج التعلم الآلي: نماذج العلماء المتنوعة والشاملة تؤدي أداءً أسوأ من النماذج الضيقة.

يمكن للتشابه البسيط تفسير ذلك. تخيل أن لديك خيارًا بين مهمتين. المهمة أ هي تحديد نوع معين من الأشجار – على سبيل المثال ، أشجار الدردار. المهمة ب هي تحديد خمسة أنواع من الأشجار: الدردار ، الرماد ، الجراد ، الزان والجوز. من الواضح أنه إذا تم منحك قدرًا ثابتًا من الوقت للتدرب ، فستؤدي بشكل أفضل في المهمة أ عن المهمة ب.

بالطريقة نفسها ، ستكون الخوارزمية التي تتعقب الجلد الأبيض فقط أكثر دقة من الخوارزمية التي تتعقب النطاق الكامل لألوان بشرة الإنسان. حتى لو كانوا مدركين للحاجة إلى التنوع والإنصاف ، يمكن للعلماء أن يتأثروا لا شعوريًا بهذه الحاجة المتنافسة للدقة.

مخبأة في الأرقام

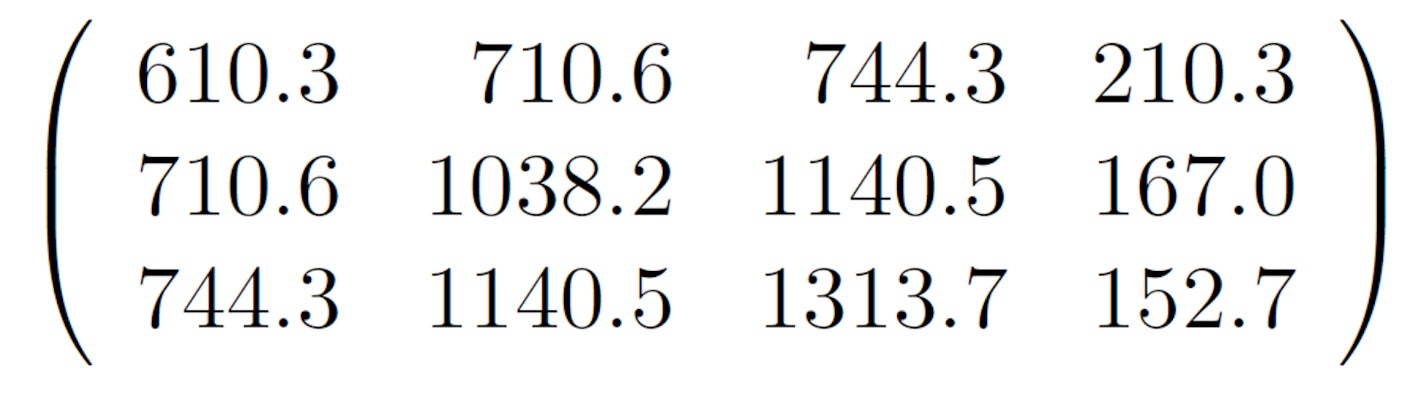

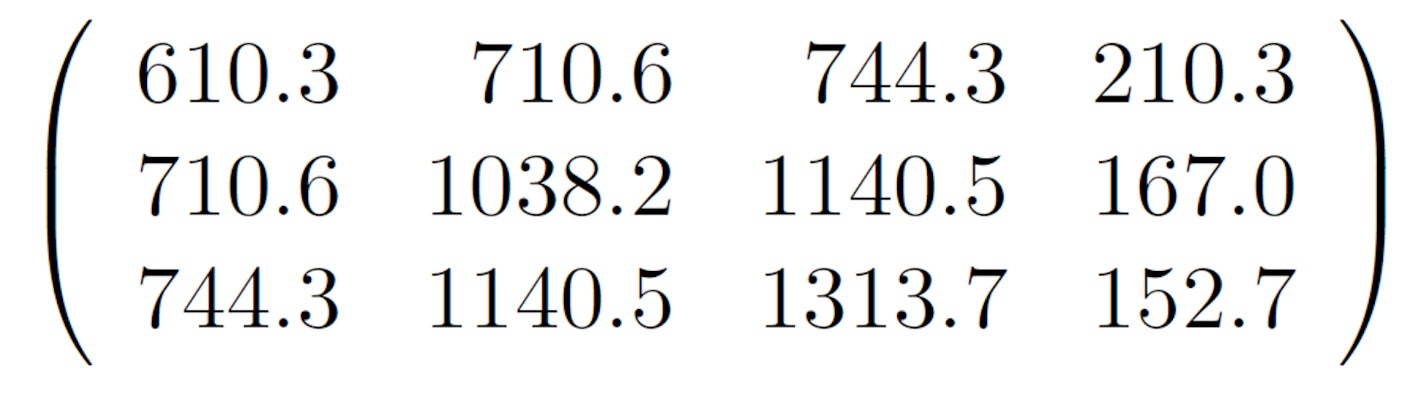

كان إنشاء الخوارزمية المتحيزة بلا تفكير وربما يكون مسيئًا. والأكثر إثارة للقلق ، يوضح هذا الحادث كيف يمكن أن يظل التحيز مخفيًا بعمق داخل نظام الذكاء الاصطناعي. لمعرفة السبب ، ضع في اعتبارك مجموعة معينة من 12 رقمًا في مصفوفة من ثلاثة صفوف وأربعة أعمدة. هل يبدون عنصريين؟ يتم التحكم في خوارزمية تتبع الرأس التي قمت بتطويرها في عام 1998 بواسطة مصفوفة مثل هذه ، والتي تصف نموذج لون البشرة. لكن من المستحيل أن نقول من هذه الأرقام وحدها أن هذه في الواقع مصفوفة عنصرية. إنها مجرد أرقام يتم تحديدها تلقائيًا بواسطة برنامج كمبيوتر.

مشكلة التحيز الذي يختبئ على مرأى من الجميع أكثر حدة في أنظمة التعلم الآلي الحديثة. غالبًا ما تحتوي الشبكات العصبية العميقة – حاليًا النوع الأكثر شيوعًا وقوة من نماذج الذكاء الاصطناعي – على ملايين الأرقام التي يمكن فيها ترميز التحيز. تم انتقاد أنظمة التعرف على الوجوه المتحيزة في “الذكاء الاصطناعي ، ألست امرأة؟” كلها شبكات عصبية عميقة.

والخبر السار هو أنه تم بالفعل إحراز قدر كبير من التقدم في عدالة الذكاء الاصطناعي ، سواء في الأوساط الأكاديمية أو في الصناعة. مايكروسوفت ، على سبيل المثال ، لديها مجموعة بحثية معروفة باسم قدر، مكرسة للعدالة والمساءلة والشفافية والأخلاق في الذكاء الاصطناعي. قدم مؤتمر رائد للتعلم الآلي ، NeurIPS ، بالتفصيل المبادئ التوجيهية الأخلاقيةبما في ذلك قائمة من ثماني نقاط للتأثيرات الاجتماعية السلبية التي يجب أن يأخذها الباحثون الذين يقدمون الأبحاث في الاعتبار.

من في الغرفة هو من على الطاولة

من ناحية أخرى ، حتى في عام 2023 ، يمكن أن يظل الإنصاف ضحية للضغوط التنافسية في الأوساط الأكاديمية والصناعية. المعيب روبوتات الدردشة الرائعة و Bing من Google و Microsoft دليل حديث على هذه الحقيقة المروعة. أدت الضرورة التجارية لبناء حصة في السوق إلى الإطلاق المبكر لهذه الأنظمة.

تعاني الأنظمة من نفس المشكلات تمامًا مثل جهاز تعقب الرأس لعام 1998. بيانات التدريب الخاصة بهم متحيزة. تم تصميمها من قبل مجموعة غير تمثيلية. إنهم يواجهون الاستحالة الرياضية للتعامل مع جميع الفئات على قدم المساواة. يجب أن يتاجروا بطريقة ما بالدقة من أجل الإنصاف. وتختبئ تحيزاتهم وراء ملايين من المعلمات العددية الغامضة.

إذن ، إلى أي مدى وصل مجال الذكاء الاصطناعي حقًا لأنه كان من الممكن ، منذ أكثر من 25 عامًا ، لطالب الدكتوراه أن يصمم وينشر نتائج خوارزمية متحيزة عنصريًا دون إشراف واضح أو عواقب؟ من الواضح أنه لا يزال من الممكن إنشاء أنظمة الذكاء الاصطناعي المتحيزة عن غير قصد وبسهولة. من الواضح أيضًا أن التحيز في هذه الأنظمة يمكن أن يكون ضارًا ويصعب اكتشافه بل ويصعب القضاء عليه.

في هذه الأيام ، من المقبول القول إن الصناعة والأوساط الأكاديمية بحاجة إلى مجموعات متنوعة من الأشخاص “في الغرفة” لتصميم هذه الخوارزميات. سيكون من المفيد أن يصل الحقل إلى هذه النقطة. ولكن في الواقع ، مع تخرج برامج الدكتوراه في علوم الكمبيوتر في أمريكا الشمالية تقريبًا 23٪ إناث و 3٪ طلاب سود ولاتينيونسيستمر وجود العديد من الغرف والعديد من الخوارزميات التي لا يتم فيها تمثيل المجموعات الممثلة تمثيلا ناقصا على الإطلاق.

هذا هو السبب في أن الدروس الأساسية في جهاز تعقب الرأس لعام 1998 الخاص بي أكثر أهمية اليوم: من السهل ارتكاب خطأ ، ومن السهل على التحيز الدخول دون أن يتم اكتشافه ، وكل شخص في الغرفة مسؤول عن منعه.

هل تريد معرفة المزيد عن الذكاء الاصطناعي وروبوتات المحادثة ومستقبل التعلم الآلي؟ تحقق من تغطيتنا الكاملة لـ الذكاء الاصطناعيأو تصفح أدلةنا إلى أفضل مولدات فنية مجانية لمنظمة العفو الدولية و كل ما نعرفه عن ChatGPT الخاص بـ OpenAI.

جون ماكورميكأستاذ علوم الحاسب كلية ديكنسون

تم إعادة نشر هذه المقالة من محادثة تحت رخصة المشاع الإبداعي. إقرأ ال المقالة الأصلية.